目次

はじめに

こんにちは! 最近、サブスク貧乏で首が360度回らない筆者です。

最近、世間の生成AIユーザーに対する軋轢も、日を追うごとに厳しくなってきて、生成AIまんが家を自称している筆者としては、いつ反AIに血祭りにあげられないかと、日々怖い思いをしている毎日です。

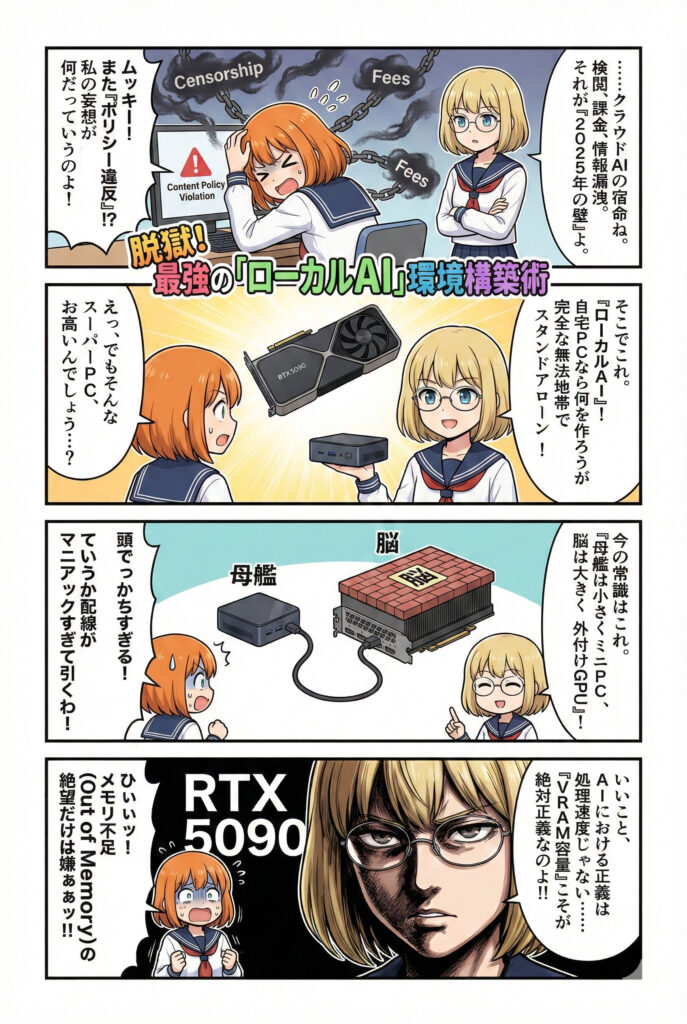

あ、さて、生成AIを使っていると、避けることが出来ないのが、この宇宙からのメッセージ。

「申し訳ありませんが、そのリクエストにはお応えできません」

「コンテンツポリシーに反しているので生成できません」

ムッキー!…なんか、ほんのちょっとでもこの生成AIからのメッセージが来るのが腹立つといいか、もう見飽きてきていませんか?

ここだけの話(ってほどでもないですが)、クラウドAIは、まぁ確かに便利っちゃあ便利ですが、検閲、プライバシー、そして毎月の課金。

まさに「2025年の崖」ならぬ「2025年の壁」に体当たりでぶつかって、額から血を流して卒倒している気分です。

そこで今回は、制限だらけの生成web AIサービスに辟易している貴兄に送る、「検閲なしの」最強AI環境を構築する方法を、徹底的に(そして少しマニアックに)解説します。

その方法とは…。自宅のPCで、生成AIを動かしてしまおうというシロモノです。

そんな事出来るのですか?…できます!STAP細胞もありまーす!

それでは、深淵なるローカルAIの沼へようこそ!

なぜ今、ローカルAIなのか?

理由は単純。「自由度」と「セキュリティ」が段違い平行棒だからです。

- 検閲フリー:クラウド上のAI(ChatGPTや、Gemini、Claudeなど)は、運営会社のポリシーにより、過激な表現や特定のトピックが制限されます。

しかし、ローカルAIなら、どんな「あんなムフフこと」や「こんなエヘヘなこと」も、モデルさえ選べば自由自在。例えば漫画のネーム作りで、ちょっとダークだったり叡智な展開を相談しても怒られません。 - プライバシー保護:あなたの書いた小説のプロット、社外秘のコード、個人的な悩み相談。これらをクラウドに送信するのは、全裸で街中を練り歩くようなもの。

「ひゅ~、服なんて着ていられるか!」

そういった性癖ならいざしらず、着たくもない服を普通の生活をしている一般ピープルにとっては由々しき問題です。

しかしローカルPCで生成AIを動かすなら、自宅で裸族マンヨロシク、LANケーブルを抜けば完全なスタンドアローン。情報漏洩のリスクは物理的にゼロになります。

やったねたえちゃん! - コストパフォーマンス:例えば 各月額3,000円×3のサブスクAIサービスに加入していたとすると、年間約10万円で鼻血ブー。これを3年続けたらハイエンドGPUが買えちゃいます。

初期投資はかかりますが、ローカルPCでAIを動かせればランニングコストは電気代だけ。

ハードウェア選定編 ~「母艦」は小さく、「脳」は大きく~

昔は「AIやるなら巨大なフルタワーPC」が常識でした。しかし2025年現在、その常識は崩れ去っています。

1.ハイスペックミニPCで充分ですよ

まず、PC本体。机の下を占領する巨大な箱はもう不要です。 ここで推したいのが、以前の記事でも紹介した、超小型なのに超ハイスペックで超コストパフォーマンスな超ミニPC「GMKtec EVO-T1」。

- CPU: Intel Core Ultra 9 285H搭載(AI処理に強いNPU搭載!でもまあ外付けGPU使うならNPUは必須ではないです。)

- サイズ: 手のひらサイズ。お弁当箱より小さい。

- 拡張性: ここが重要。「Oculink」ポートを搭載していること。

Thunderbolt 4 (USB4)でもeGPU(外付けGPU、ようするに生成AIの高速化に必須の「ビデオカード」とほぼ同義)は繋がりますが、帯域幅がボトルネックになりがち(ようするにマザーボードに直付けするよりスピードが落ちる)。

しかし、OculinkならPCIe Gen4 x4の帯域をほぼダイレクトに使えます。これが「ミニPCでも最強」になれる理由です。

二つで充分ですよ!

2. GPU:VRAMこそが正義

AI(特に画像生成や大規模言語モデル)において、最も重要なのはGPUのVRAM(ビデオメモリ)容量です。処理速度ではありません。容量です。

- 8GB: 入門用。SDXLやFlux.1などの最新モデルは動くけど、すぐ「Out of Memory」で落ちる。ストレスでハゲます。

- 12GB (RTX 3060/4070等): 最低ライン。 これがあれば、とりあえずの画像生成や軽めのLLM(大規模言語モデル)は快適。

- 16GB (RTX 4060 Ti 16GB / 4080): 推奨ライン。 学習(LoRA作成)や、少し大きめのモデルも動かせる、コスパのスイートスポット。筆者はRTX5080(16GB)を使用中。中古でも15万円もした…。

- 24GB (RTX 3090 / 4090 / 5090): 神の領域。 巨大クラスのLLMを量子化して動かしたり、超高解像度のマンガ生成が可能。まわりの生成AIユーザーの垂涎の的になること間違いない!

3. 構成例:最強にかなり近いローカル生成AI用PCの構成(筆者環境)

- PC: GMKtec EVO-T1 (96GB RAM)

- GPU: 中古のRTX 5080 (16GB)

- 接続: Oculinkケーブル

- 電源: GPU用のATX電源を別途用意

この構成なら、普段は省電力なMini PCとして使い、AI生成時だけGPUの電源をオンにする運用が可能。電気代にも優しい(はず)!

ソフトウェア導入編 ~黒い画面を恐れるな~

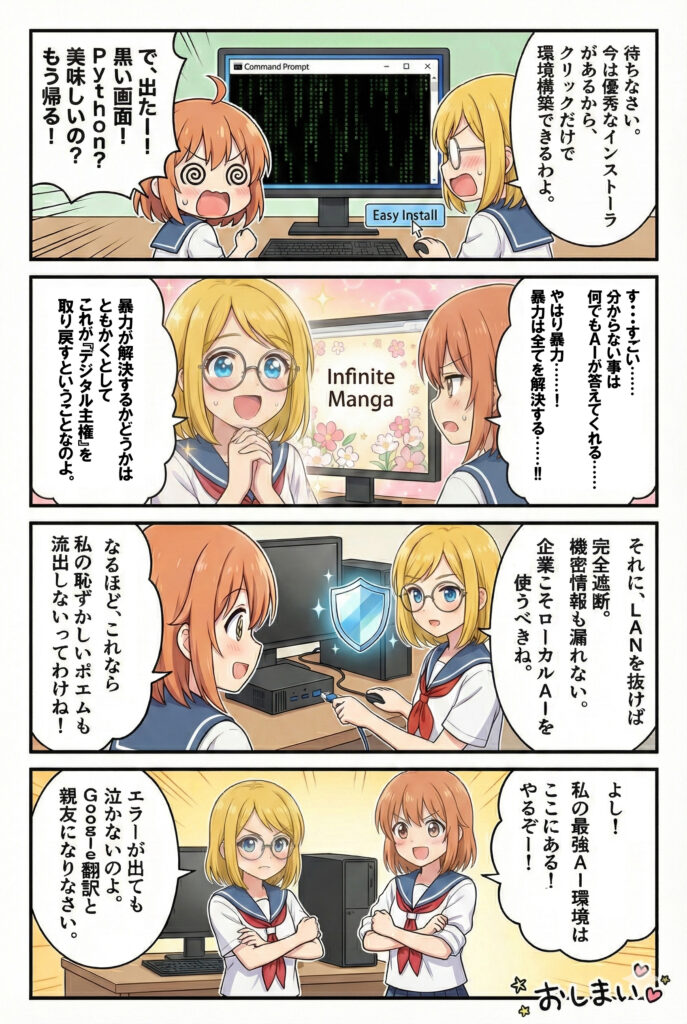

ハードが揃ったら、次は魂(ソフト)を吹き込みます。「Python? 美味しいんですかソレ?」という人でも大丈夫。最近はインストーラーが優秀です。

1. 大規模言語モデル (LLM) の導入:Ollama + Open WebUI

チャットAIをローカルで動かすなら、Ollamaの選択肢が考えられます。

- 公式サイトからOllamaをダウンロードしてインストール。

- ターミナル(コマンドプロンプト)で

ollama run llama3と打つ。 - Open WebUIをDockerで入れれば、見た目はほぼChatGPTになります。ようするにコマンドライン上でポチポチAIを動かせる仕組みです。

大半のライトユーザーにはなじみが無いですが、エンジニアさん的にはこっちの方が使いやすいらしいです。筆者も正直あまりよく分かっていないです。

おすすめモデル:

- Llama-3-8B: 軽くて賢い。英語ベースですが日本語もそこそこいける。

- DeepSeek-R1 (Distill): 最近話題の「蒸留」モデル。軽量なのに推論能力が高い。中国発のモデルですが、ローカルで動かす限りデータは漏れません。検閲も(モデルによりますが)緩めです。

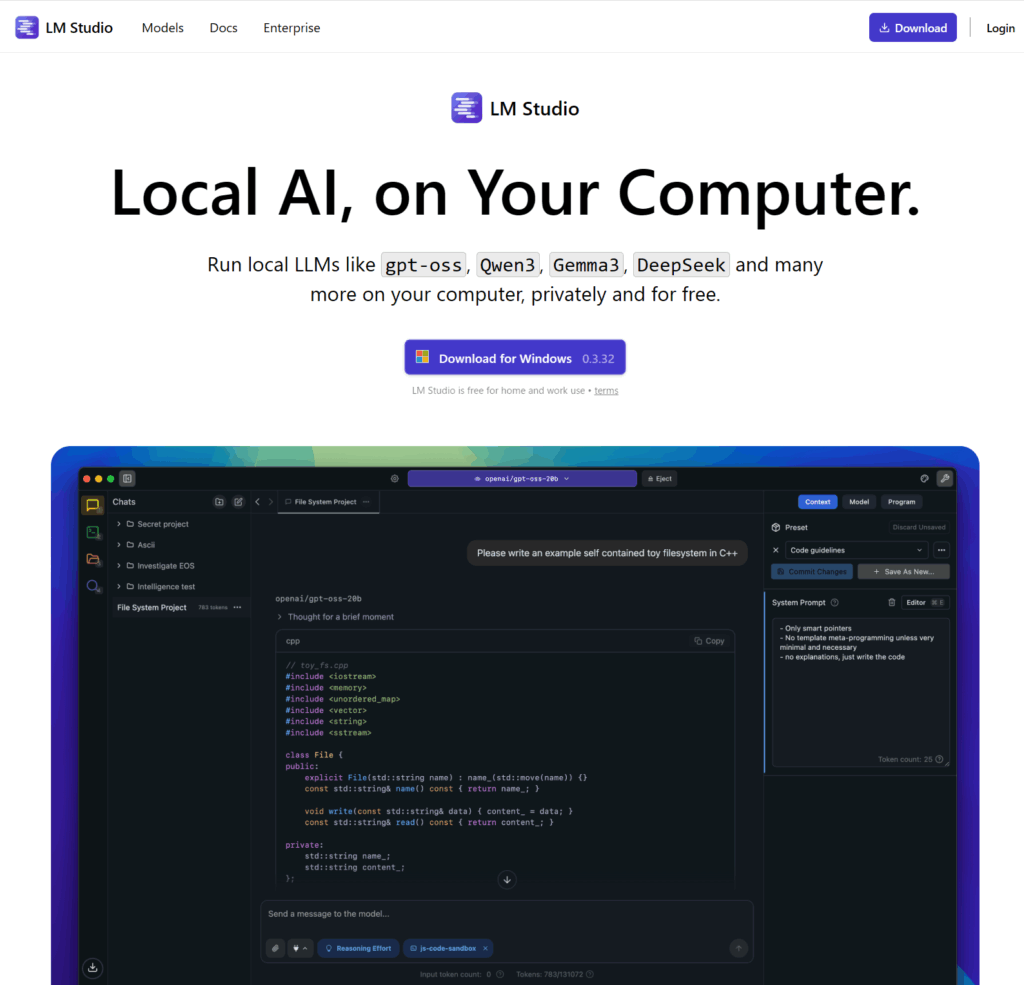

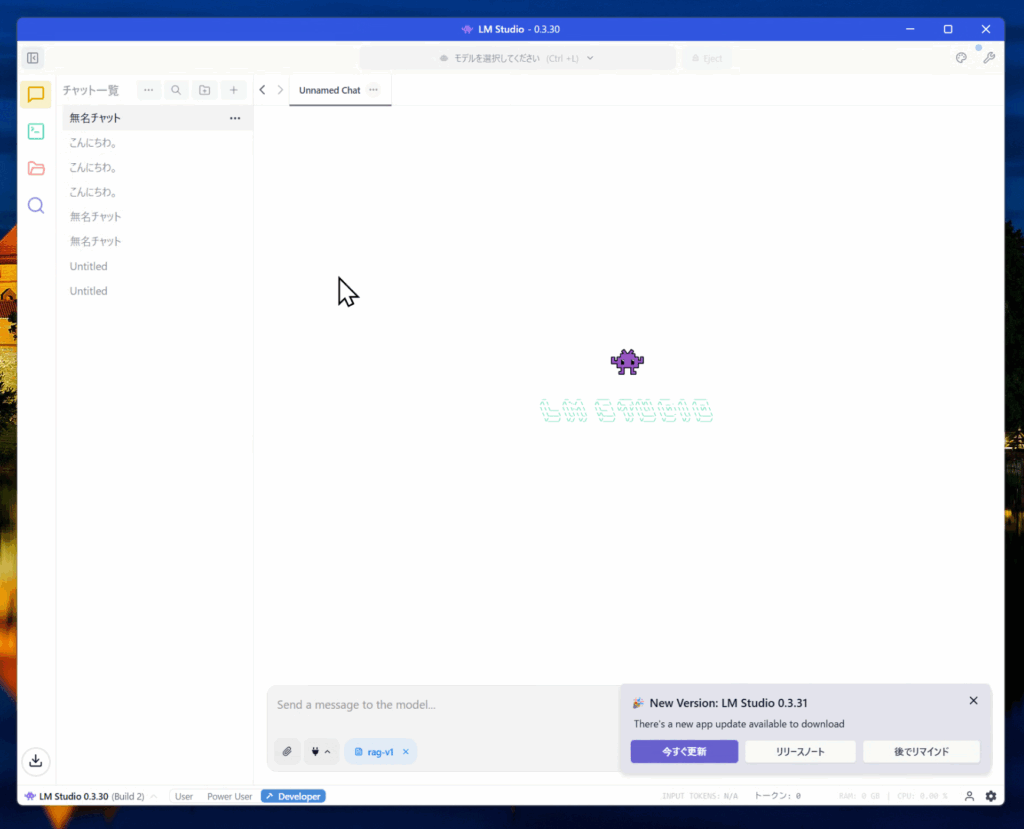

…と、これだけの説明だと敷居が高すぎて何が何だか分からないと思うので、初心者向けは「LM Studio」がお勧め。ようするにフツーのWindows アプリです。

公式サイトで実行ファイルをダウンロードします。

https://lmstudio.ai

ダウンロードして実行すると、アプリが起動します。虫眼鏡マークをクリックすると、主だったローカルで動くLLMが選択できるので、ダウンロードして、あとはチャットアイコンで会話を開始するという塩梅です。いわゆる生成AIのサービスの操作方法とほぼ同様です。

ただし、残念ながら、画像生成はできません。ざんねん!

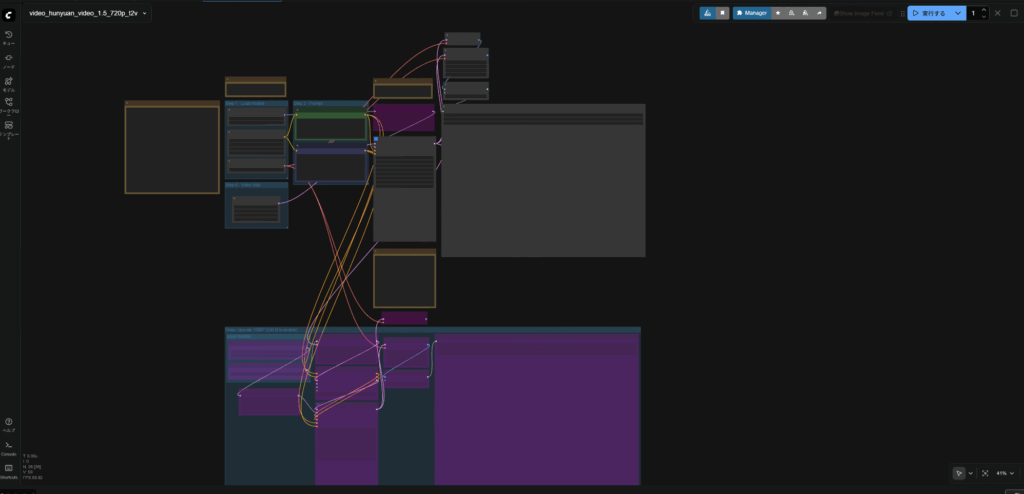

2. 画像生成AIの導入:ComfyUI

ローカルで動く画像生成と言えば、まず真っ先に思い浮かぶのが「Stable Diffusion 」。ようするに、PC単体でAI絵が生成できる代名詞のようなシステムです。エエエッな絵を生成可能です(記事執筆時点。将来は知らん)

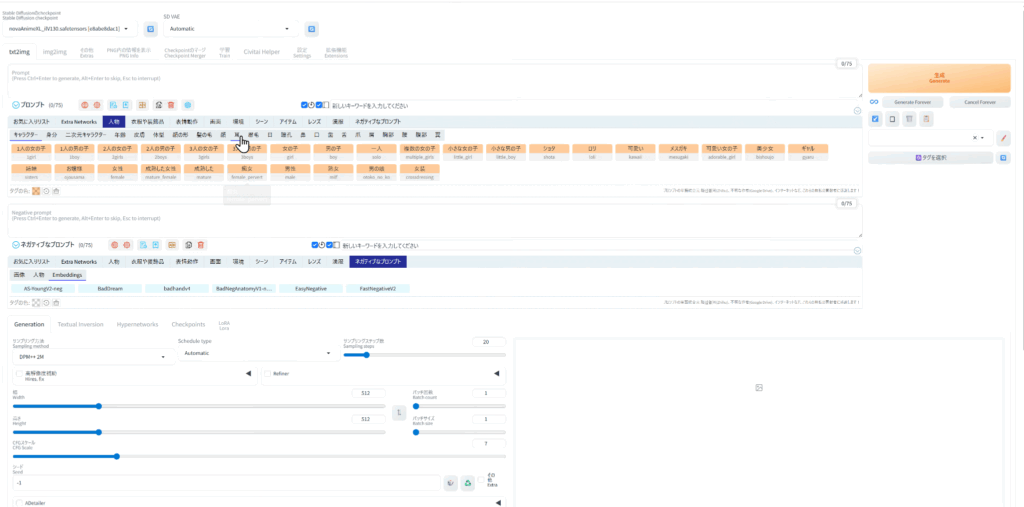

UIは、「Stable Diffusion WebUI (A1111)」も良いですが、2025年のスタンダードはComfyUIです。A111の上位互換みたいなもんだと思ってもらえればいいです。従って、利用できるデータにある程度互換性があります。

特に複雑なワークフロー(画風指定、カメラアングル、キャラ固定を一括処理)を組むには、ノードベースのComfyUIが必須です。

- 導入: 「Stability Matrix」という管理ツールを使えば、ワンクリックでインストール完了。「Stable Diffusion WebUI (A1111)」も「ComfyUI」両方とも使え、Pythonのバージョン管理地獄(バージョンが合わない!というエラーに一番悩まされるので)から解放されます。このソフトもダウンロードして実行するだけです。

- 必須Extension:

ComfyUI-Manager: これがないと始まらない。ControlNet: ポーズ指定に必須。マンガのコマ割り通りにキャラを配置できます。IPAdapter: キャラクターの顔や服装を固定するために使います。

実践! AIマンガ制作テクニック

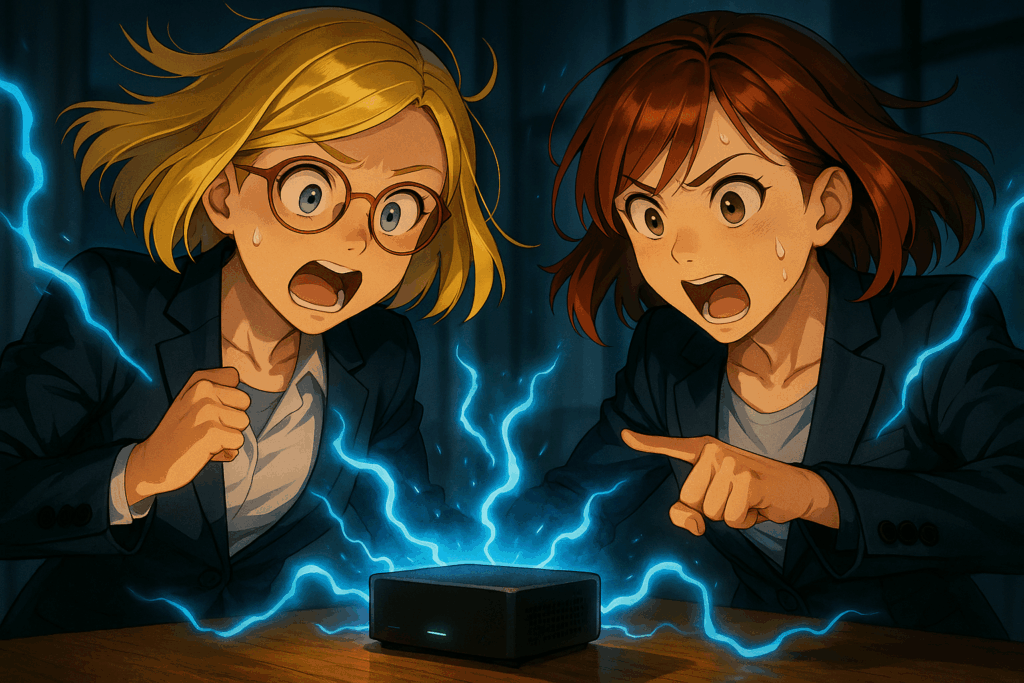

さて、ローカル環境ができたら何を作りますか? もちろん叡智なAIマンガですよね! (描かないのに漫画家を名乗る筆者のような人種が増えています!)

1. キャラクターの固定

AIマンガ最大の課題は「コマごとに顔が変わる問題」。以下の機能を駆使します。

- LoRA : 特定のキャラクター(例えば「金髪メガネっ娘」や「赤髪の活発女子」)を学習させたLoRAを作成します。強力なGPUが必須です。

- Seed固定の罠: シード値を固定しても、プロンプトが変われば絵は変わります。シード固定よりも、

IPAdapterで参照画像を読み込ませる方が、顔の安定度は劇的に向上します。

2. 画風の統一

「アニメ風」や「劇画調」など、特定の画風を維持したい場合。 プロンプトに style of Animation と入れるだけでは弱いです。ここでもLoRA、あるいはCheckpoint(モデル本体)の選定が重要。 アニメ調なら Pony Diffusion 系の派生モデルが、2025年現在でも最強の追従性を持っています。ただし、検閲フリーすぎて何でも出ちゃうので、職場での閲覧は要注意(笑)。

3. コマ割りとカメラワーク

「アオリ」のようなダイナミックな構図を出すには、プロンプトだけでなく、ControlNetの Depth や OpenPose を使います。 3Dデッサン人形でポーズを作って、それをAIに「この構図で描いて!」と渡す。これが現在の主流です。AIは「描く」ツールではなく「レンダリング」ツールになったのです。

4.セキュリティと「2025年の崖」

少し真面目な話を。DX(デジタルトランスフォーメーション)の遅れが叫ばれる日本ですが、企業がクラウドAIを導入する際、最大の懸念事項となるのが「情報漏洩」です。

「社内の極秘データをChatGPTに入力して要約させた」なんて事案が後を絶ちません。 しかし、今回紹介したローカルAI環境を社内サーバー(オンプレミス)に構築すれば、データは一歩も外に出ません。

ハイスペックなMini PCは、省スペースで低消費電力なので、小規模オフィスの「専有AIサーバー」としても優秀です。 「クラウドか、オンプレミスか」という二元論ではなく、「機密情報はローカルLLM、一般情報はクラウド」というハイブリッド運用が、2025年の最適解となるでしょう。

5.自由には「責任」が伴う:ライセンスとバイアスの落とし穴

さて、ここまで「ローカル最高! 自由バンザイ!」と煽り倒してきましたが、最後に冷や水をぶっかけるような話をしなければなりません。

前回の記事で紹介した「Cloudflare訴訟」を覚えていますか? 海賊版サイトのインフラ提供者が訴えられた話です。

ローカルAI環境を構築するということは、「あなた自身が、あなただけのCloudflare(インフラ管理者)になる」ということです。

つまり、クラウドサービスの規約(検閲)から解放される代わりに、全責任があなた一人にのしかかることを意味します。

- ライセンスの罠(商用利用不可): ネットに落ちている「神モデル」や「最強LoRA」のすべてが、商用利用OKなわけではありません。「CreativeML Open RAIL-M」ライセンスなら比較的自由ですが、「CC BY-NC(非営利のみ)」と書かれたモデルを使ってマンガを描き、それを販売したら……はい、一発アウトです。訴状が届いても、GoogleやOpenAIは守ってくれません。

- 学習データのバイアス: ローカルモデルは、学習データの影響をモロに受けます。例えば、特定のバイアスがかかったモデルを業務で使うと、無意識に差別的な出力や、著作権的にグレーな(特定の作家の絵柄に酷似しすぎた)画像を生成してしまうリスクがあります。 「検閲がない」ということは、「安全フィルターがない」ということ。その出力物が、世に出して大丈夫なものかどうか、判断するのはAIではなく、人間のあなたです。

自由を手に入れるということは、無法地帯の王になることではなく、自律した管理者になることなのです。

まとめ

自宅にローカルAI環境を構築することは、単なる趣味ではありません。それはデジタル主権を取り戻す行為です。

- 「GMKtec EVO-T1」のような高性能Mini PCを用意する。

- Oculinkで強力なGPU(VRAM 16GB以上推奨)を接続する。

- ComfyUIとOllamaもしくはLM Studioで、検閲のない自由な創作環境を作る。

- そして、生成するコンテンツの権利と倫理を(自分で)守る。

これで、あなたも「AIマンガ家」としてデビューできます。 初期設定でつまづくかもしれませんが、エラーログ(赤い文字)とサッカーボールは翼君とコナン君の友達です。

英語のエラーメッセージが出ても、そこで諦めたらそこで試合終了ですよ。生成AIやGoogle翻訳に突っ込めば、解決策は必ず見つかります。 もしRTX 5080でStable DiffusionやComfyUIが動かないときは…ええと、PyTorchのバージョンとCUDAの互換性を疑ってください(経験談)。

それでは、良きローカルAIライフを! STAP細胞はありませんが、ローカルAIの可能性は無限大にありまーす!

参考文献

Ollama

SMOOZ/ローカルLLMのすゝめ。Windows環境でのOllama(オラマ)を使った生成AI利用方法について

LM Studio

ChatGPTlab/【入門】LM Studioの使い方 – ローカルLLMの導入からDify連携まで

Wikipedia/Stable Diffusiion

Github/LykosAI/StabilityMatrix

note/Stability Matrixの導入と設定方法ガイド

Lycos/Stability Matrix

おまけ漫画(ネームから仕上げまで全てgemini/Nanobanana Proのみで生成しております。)